На сегодняшний день процесс модерирования контента является чем-то крайне сложным — это уже не «то модерирование», которое было актуально на различных платформах лет 10 назад. Сейчас модераторы-люди постоянно вынуждены в реальном времени реагировать на стремительно меняющиеся тенденции, а также анализировать различные посты и сообщения пользователей на предмет присутствия в них, например, теорий заговора о вакцинации, различного рода дезинформации, либо же умышленных попыток причинить вред.

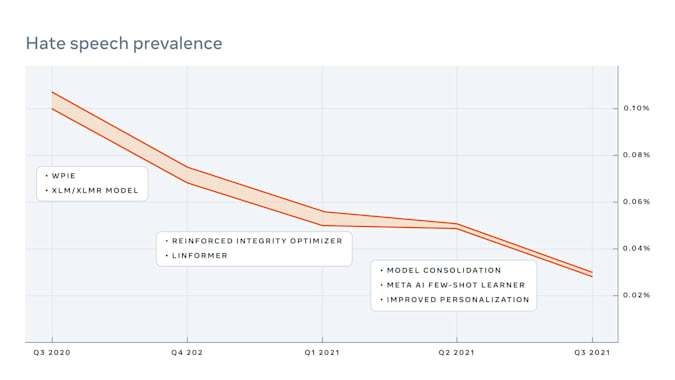

И именно системы машинного обучения способны как нельзя лучше помочь облегчить часть данного бремени за счёт хотя-бы частичной автоматизации процесса модерирования может искусственный интеллект. Но всё же никак нельзя поспорить и с тем, что современные системы автоматизации точно также не идеальны. Привести их в более удобоваримое состояние решила корпорация Meta, которая, как стало известно, совсем недавно провела испытания системы, именованной как Few-Shot Learner. И В целом, первые результаты оказались обнадёживающими. Исследователи из Meta изучили изменение распространённости вредоносного контента, показываемого пользователям Facebook и Instagram до и после активации системы отображения, поиска и фильтрации, чем и является FSL.

В результате система сумела крайне быстро обнаружить вредный контент, который пропустили обычные модели машинного обучения. Более того, она также сразу снизила распространённость подобного контента в целом. Именно поэтому технический гигант уже сейчас сообщил о том, что система FSL превзошла многие другие модели ИИ на целых 55 процентов. Однако справедливости ради отметить необходимо и то, что средний показатель «корректной продуктивности» составляет только 12 процентов, что тоже очень неплохо. Улучшение показателей деятельности ИИ с применением FSL отчасти объясняется тенденцией, определяемой самой компанией как «действие или факт возникновения или вовлечения по необходимости или как следствие».

По своей же сути, это логическое следствие между двумя предложениями — если предложение «A» истинно, то предложение «B» также должно быть истинным. Другими словами, если предложение «A» звучит как «Президент был убит», то из этого следует, что предложение «B», «Президент мёртв», точно также является верным, точным и правильным, не требующим дополнительного рассмотрения операторами-людьми на предмет дезинформации. Так что в тот самый момент, когда вышеназванная система будет доработана и встроена в платформы компании, они явно станут куда более безопасными и менее дезинформирующими.